Da una parte troviamo la fazione di chi, come David Patterson, professore della University of California – Berkeley, crede che stiamo andando verso un Rinascimento dell'architettura dei computer, periodo eccitante caratterizzato da una molteplicità di nuove scoperte. Dall'altra parte, invece, ci sono scienziati che restano maggiormente con i piedi per terra e, pur riconoscendo il declino della Legge di Moore, insistono nel dire che il futuro che ci attende (almeno a breve termine) non è così differente dal presente che viviamo.

Tutti, da una parte e dall'altra, devono fare i conti con l'effetto Joule e la dissipazione del calore. Il più grande ostacolo che si frappone tra i produttori di chip e circuiti integrati e la possibilità di continuare a rispettare la Legge di Moore sta proprio nelle difficoltà che si incontrano nel dissipare il calore generato dalla corrente che passa attraverso i transistor. Il limite fisico, già raggiunto, è quello dei 150 Watt per centimetro quadrato e altre strategie per la dissipazione sembrano essere poco praticabili (soprattutto per una questione di costi).

Ciò ha costretto i produttori ad abbandonare la strada della potenza pura (ossia, aumento senza freni della frequenza operativa delle CPU) e intraprendere quella del multicore. Anche su questo fronte, però, si sta andando verso l'ennesimo collo di bottiglia tecnologico: architetture con più di otto core sono poco efficienti e garantiscono ben pochi vantaggi rispetto ai costi produttivi e sono quindi impraticabili (o quasi). La nuova frontiera, in parte già esplorata (si pensi alle differenze tra CPU e GPU), sembra essere quella della specializzazione.

L'architettura big.LITTLE e i coprocessori degli smartphone

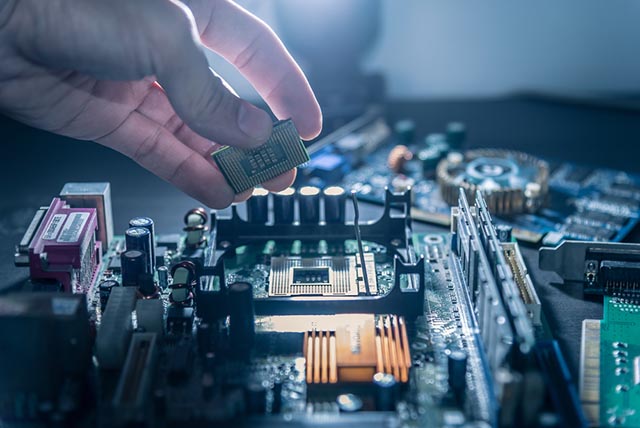

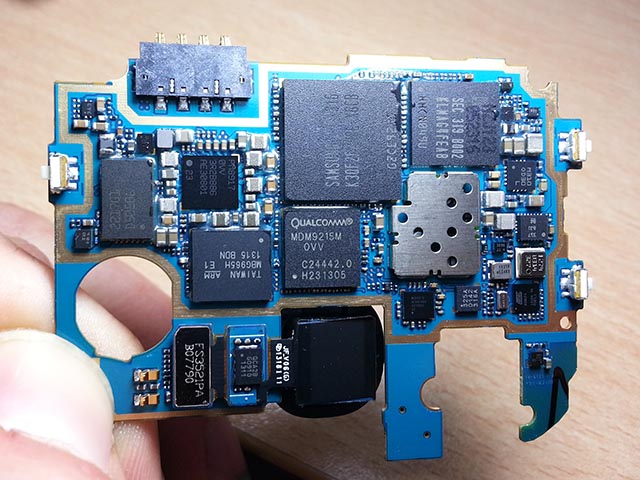

Come mostrato già da alcuni produttori di smartphone e dispositivi mobili, la strada da percorrere per ovviare al declino della Legge di Moore sembra essere quella delle CPU specializzate. Già da diversi anni, ad esempio, Apple ha iniziato a introdurre all'interno degli iPhone dei processori complementari (detti coprocessori) dedicati a compiti specifici. C'è il coprocessore M che si occupa di gestire i sensori e analizzare i flussi di dati in ingresso; mentre il chip W1 gestisce più efficientemente il Bluetooth e il flusso di dati audio una volta che si connette il melafonino con gli auricolari AirPods.

La strada della specializzazione è stata intrapresa anche da ARM, di fatto il più grande produttore di SoC e CPU per smartphone e altri dispositivi mobili. Il produttore britannico ha introdotto l'architettura big.LITTLE, grazie alla quale riesce a massimizzare le prestazioni dello smartphone tenendo sempre sotto controllo i consumi energetici. All'interno di questa architettura, le unità di calcolo sono divise tra quelle dedicate all'esecuzione delle applicazioni attualmente in uso (che assicurano prestazioni elevate) e quelle dedicate all'esecuzione delle app in background (che massimizzano l'efficienza energetica). A queste unità "centrali" si affiancano quelle periferiche, dedicate alla gestione di specifiche funzionalità dei dispositivi (gestione dell'alimentazione, sensori, comparto audio-video, connettività e così via).

Problema software

L'eccessiva specializzazione delle CPU potrebbe portare con sé anche degli effetti indesiderati. Da una prospettiva di chi sviluppa software, infatti, la proliferazione di nuovi processori è quanto di peggio ci si potesse aspettare. Ogni nuovo chip e ogni nuova architettura necessitano dei propri strumenti di programmazione e dei propri compilatori, così che le istruzioni possano essere eseguite correttamente. Ciò potrebbe portare a una frammentazione delle soluzioni software mai vista nel campo della programmazione, costringendo gli sviluppatori a specializzarsi ancora di più di quanto non lo siano già ora. Le possibili soluzioni, in questo caso, sono due: la realizzazione di framework di programmazione specializzati e l'esecuzione diretta del linguaggio.

La prima prospettiva permetterebbe di realizzare software e app che siano indipendenti dalla piattaforma hardware che li dovrà eseguire lasciando la patata bollente tra le mani dei produttori di CPU. Saranno loro, infatti, a dover decidere come e quale framework supportare affinché i programmi possano girare sui loro chip e coprocessori. La seconda, invece, prevede che i processori eseguano direttamente le istruzioni fornite loro attraverso un linguaggio di alto livello (come Java, ad esempio) senza dover passare attraverso "intermediari" come i compilatori. Pur garantendo una maggiore efficienza e, probabilmente, un'esecuzione più veloce delle istruzioni e quindi del software, questa strada non ha trovato al momento molti estimatori.

La via quantistica

Se si fa un passo indietro e si torna sul sentiero della potenza pura, la strada più promettente è quella dell'informatica quantistica. Da qualche anno a questa parte, il numero di aziende e produttori che investono – anche ingentemente – in questo settore è in rapida crescita: slegandosi dai limiti mostrati dalle architetture CPU "classiche" e poggiando sulle fondamenta della fisica quantistica, i chip quantistici sono in grado di garantire prestazioni migliaia di volte superiori a quelle dei chip al silicio odierni.

Si tratta, però, di un percorso molto lungo e siamo ancora alle primissime battute. D-Wave, società britannica controllata da Google specializzata nella creazione di sistemi quantistici, è certa che nell'arco di un quinquennio la gran parte dei supercomputer e dei datacenter farà affidamento su computer basati sul qubit, ma è ancora troppo presto per prevedere come e quando i chip quantistici potranno arrivare sul mercato "generalista".