L’intelligenza artificiale è in grado di rivoluzionare interi settori professionali, ma cosa accadrebbe se finisse nelle mani degli hacker? La domanda è legittima, considerate le potenzialità mostrate da strumenti come ChatGPT e DALL-E.

I risultati ottenuti dalle AI potenzialmente possono essere utilizzati per realizzare diversi tipi di attacco hacker: dal phishing alla diffusione di malware. Dalla realizzazione di deepfake ad attività più vaste di social engineering.

Intelligenza artificiale e phishing potenziato

.jpg)

Credits Shutterstock

Negli ultimi mesi ChatGPT (spesso scritto erroneamente Chat GPT) ha mostrato a tutto il mondo le potenzialità di un chatbot basato su intelligenza artificiale e machine learning.

Tutti i sistemi in grado di generare testo basati su AI sono strumenti potenzialmente nocivi se utilizzati per realizzare un attacco hacker. Si pensi in tal senso al phishing: un reato online che inganna l’utente con l’obiettivo di ottenere informazioni sensibili.

Negli attacchi di phishing tradizionali il truffatore si nasconde dietro il nome di un’autorità o di un’entità legittima. Annuncia un pericolo o un vantaggio imminente e spinge la vittima a cliccare su un link, effettuare un accesso o compilare un form. Con il rischio di installare malware o permettere l’accesso ai propri dati personali.

Applicare l’intelligenza artificiale al phishing permetterebbe di personalizzare gli attacchi con pochi clic. Al punto tale da renderli quasi indistinguibili da una comunicazione reale. Il rischio è che gli hacker imparino a utilizzare chatbot altamente sofisticati per attuare lo spear phishing o addirittura il social engineering. Due diciture che vengono utilizzate nel caso in cui l’attacco sia quasi cucito addosso alla vittima.

Ciò vuol dire raccogliere informazioni sulla vittima in modo da realizzare una comunicazione molto più credibile e, di conseguenza, molto più pericolosa.

Deepfake e social engineering

.jpg)

Credits Shutterstock

Un’altra applicazione ormai celebre dell’intelligenza artificiale sono i cosiddetti sistemi di deep learning: quelli capaci di replicare alla perfezione il volto, la voce o le movenze di una persona reale.

Nel caso in cui l’utilizzo di queste tecnologie sia improprio si parla anche di deepfake. E anche il deepfake, proprio come i chatbot, ormai può venire interrogato ottenendo risultati a tempo di record. Ad esempio esistono servizi che restituiscono una sintesi vocale completa a fronte dell’invio di pochi campioni registrati.

Dunque l’intelligenza artificiale permette a un hacker di clonare la voce o i tratti di chiunque voglia. Un presupposto che rende molto più semplice proprio il social engineering cui si accennava nei capoversi precedenti.

Per avere un’idea più chiara della minaccia basta pensare allo scenario che segue: l’hacker telefona alla vittima e registra la sua voce con l’obiettivo di clonarla. Dopodiché sfrutta l’AI e ricorre a un sistema di sintesi vocale per potersi spacciare proprio per la sua vittima.

Per fortuna ad oggi i sistemi più avanzati di sintesi vocale richiedono una collaborazione continuativa da parte dell’utente. Ad esempio la tecnologia Revoice di Podcastle realizza una sintesi completa soltanto nel caso in cui il committente invii ben 70 frasi distinte.

Cracking dei codici e machine learning applicato ai malware

Credits Shutterstock

L’intelligenza artificiale di ChatGPT è in grado di generare centinaia di righe di codice nel giro di pochi minuti. La sua velocità è infinitamente superiore rispetto a quella dell’essere umano anche nel caso in cui vada effettuata un’analisi di codice preesistente.

Qui tornano in gioco gli hacker, che possono benissimo sfruttare le potenzialità dell’AI per setacciare codici con l’obiettivo di individuare falle, errori o vulnerabilità.

Per non parlare poi del fatto che l’intelligenza artificiale potrebbe addirittura rendersi protagonista di un attacco hacker. Il modello di apprendimento automatico di ChatGPT può essere utilizzato anche per scrivere direttamente dei malware.

Qui il pericolo maggiore è rappresentato dal machine learning: l’apprendimento automatico che permette al programma di gestire quantità enormi di dati. Di analizzarli e combinarli, estraendo regole inedite.

Se il machine learning venisse applicato con metodo ai malware, l’utente si troverebbe di fronte a programmi malevoli con una capacità di adattamento mai vista prima. Software capaci di ovviare alle contromisure grazie ad aggiornamenti automatici continui.

Intelligenza artificiale generativa e dati falsi

Credits Shutterstock

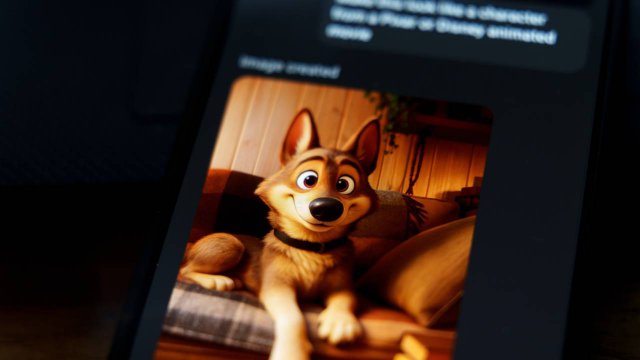

Il successo internazionale di uno strumento come DALL-E ha mostrato al mondo altre possibili applicazioni dell’intelligenza artificiale: la realizzazione in tempo reale di immagini, video o audio a partire da una descrizione testuale.

Il problema di questi contenuti è che, tecnicamente parlando, non possono essere considerati dei falsi. Dunque chiunque può generare un’immagine verosimile e magari utilizzarla per associarla a uno o più profili sui social network. Ma non solo, considerato che con pochi input è possibile associare un volto alla descrizionedi una vita immaginaria con cui completare il profilo.

Se l’AI dovesse continuare a progredire i social potrebbero non essere più in grado di contenere la proliferazione di falsi profili. E quest’ultima renderebbe molto più semplice la circolazione di fake news, campagne di disinformazione o addirittura truffe dirette a utenti reali.

Ancora una volta basta viaggiare con la fantasia per avere un’idea più chiara delle possibili criticità future. Immaginiamo che un account che mostra la foto di un attore famoso pubblichi un video in cui lo stesso attore famoso chiede ai suoi follower di investire in un prodotto o servizio.

Immaginiamo ora che i contenuti di cui sopra siano tutti dei “falsi”, realizzati con l’intelligenza artificiale da un hacker. Cosa succederebbe se gli utenti non fossero più in grado di distinguere la copia dall’originale? Difficile dirlo, ma a onor del vero è anche difficile non preoccuparsi.

Per saperne di più: Intelligenza Artificiale, cos'è e cosa può fare per noi