Il discorso sui Large Language Models (LLM) è strettamente connesso a quello dei chatbot AI, una tecnologia che ormai sta diventando sempre più comune ma di cui molti ancora ignorano il funzionamento.

In questo senso un LLM può essere considerato come “lo scheletro” di un qualsiasi chatbot come ChatGPT, ad esempio, e gli consente di comprendere le domande degli utenti, elaborare quanto richiesto e fornire risposte efficienti in tempi brevi. Scopriamo di più al riguardo.

La storia degli LLM

a-image/Shutterstock

L’idea dietro ai Large Language Models non è così recente come si pensa e, in realtà, esiste da quasi 100 anni, solo che dopo essere stata teorizzata per la prima volta negli anni '30 del '900 è rimasta solamente una teoria brillante ma, ovviamente, non realizzabile con le tecnologie dell’epoca.

Nel 1967 ha visto la luce ELIZA, quello che può essere considerato il primo computer conversazionale della storia e si trovava all’interno del MIT (Massachusetts Institute of Technology).

Senza entrare troppo nello specifico questo dispositivo si serviva una serie di script conversazionali che utilizzava per rispondere alle domande degli utenti. Naturalmente non bisogna immaginare le potenzialità dell’attuale tecnologia dietro ChatGPT, ma comunque all’epoca ha rappresentato una grande invenzione.

La prima idea di LLM risale al 1930 quando, naturalmente, questa intuizione venne elaborata rimendo per circa 100 anni solo una brillante teoria

Chiaramente, nonostante l’idea alla base del progetto, ELIZA non ha molto a che fare con le attuali tecnologie dei chatbot AI che hanno richiesto quasi 50 anni di evoluzione prima di diventare una realtà alla portata di tutti.

Nel 2013, è arrivato word2vec, uno dei primissimi algoritmi di elaborazione del linguaggio naturale (NLP) in grado di prendere una parola e convertirla in una matrice di numeri, chiamata anche vettore.

Anche qui, un sistema piuttosto complesso, ma ancora parecchio lontano da ciò che possiamo fare oggi con i chatbot a disposizione, ma che comunque ha rappresentato un grande passo avanti nel settore.

Il primo vero LLM è stato BERT, una soluzione sviluppata nel 2019 per migliorare l’algoritmo del motore di ricerca di Google per aiutarlo a “comprendere” meglio le ricerche degli utenti e, naturalmente, fornire risultati migliori.

L’arrivo sul mercato di ChatGPT, invece, risale al 2022, quando questo sistema ha spianato la strada a tutte le tecnologie che gradualmente stanno conquistando tutti i settori della tecnologia, compiendo quasi quotidianamente passi da gigante in materia.

Come funzionano i Large Language Models?

Jamie Jin/Shutterstock

Come ben noto a tutti una delle parti fondamentali di un LLM è la “formazione”, che può essere considerata come una sorta di addestramento che alimenta il modello con una grandissima quantità di dati.

Libri, articoli, siti, testi e qualsiasi cosa possa formare il programma e aiutarlo a “imparare” un determinato argomento per fare in modo che possa rispondere efficientemente alle richieste degli utenti.

Naturalmente il tipo di addestramento varia a seconda della tipologia di LLM che si prende in considerazione, se consideriamo DALL-E, ad esempio, il suo fine ultimo è fornire un’immagine partendo da un input testuale.

Questo richiede una formazione diverse rispetto a un chatbot solo testuale e, in questo caso, sarà necessario un addestramento che comprende anche immagini di diversa natura.

Tornando ai chatbot “classici”, dopo l’addestramento il testo viene suddiviso in “token”, queste piccole unità possono rappresentare una parola, un segno di punteggiatura e qualsiasi cosa possa aiutare il modello a analizzare piccole porzioni di informazioni in modo da renderne più efficiente il funzionamento.

Un’altra caratteristica cruciale di questa tecnologia è rappresentata dalle reti neurali che consentono al sistema di prevedere quali parole verranno utilizzate nella progressione di una frase, aiutandoli a contestualizzare ciascun termine.

Una parte fondamentale del discorso sugli LLM è l’addestramento che richiede enormi quantità di dati affinché un chatbot, ad esempio, possa rispondere alle domande degli utenti

Questo procedimento consente al modello di dare un senso coerente a un testo e di proporre all’utente risposte pertinenti con quanto richiesto.

L’analisi del contesto avviene tramite una rappresentazione vettoriale, con ciascuna parola che viene rappresentata come se fosse un vettore, in modo da aiutare il modello a comprendere il significato delle parole con un sistema matematico.

Naturalmente è bene ricordare che un LLM tiene in considerazione anche la sintassi delle frasi, valutando sia il significato delle parole, ma anche il modo in cui sono posizionate all’interno di una frase. Così facendo le risposte non solo sono efficaci ma anche grammaticalmente corrette.

Molto importanti in questo discorso anche quelli che vengono chiamati meccanismi di attenzione, che consentono al modello di dare un peso maggiore ad alcune parti del testo partendo, appunto, dal contesto.

In questo modo il modello saprà dare risposte più accurate ponendo maggiore attenzione proprio su quelle che considera le parti chiave del discorso.

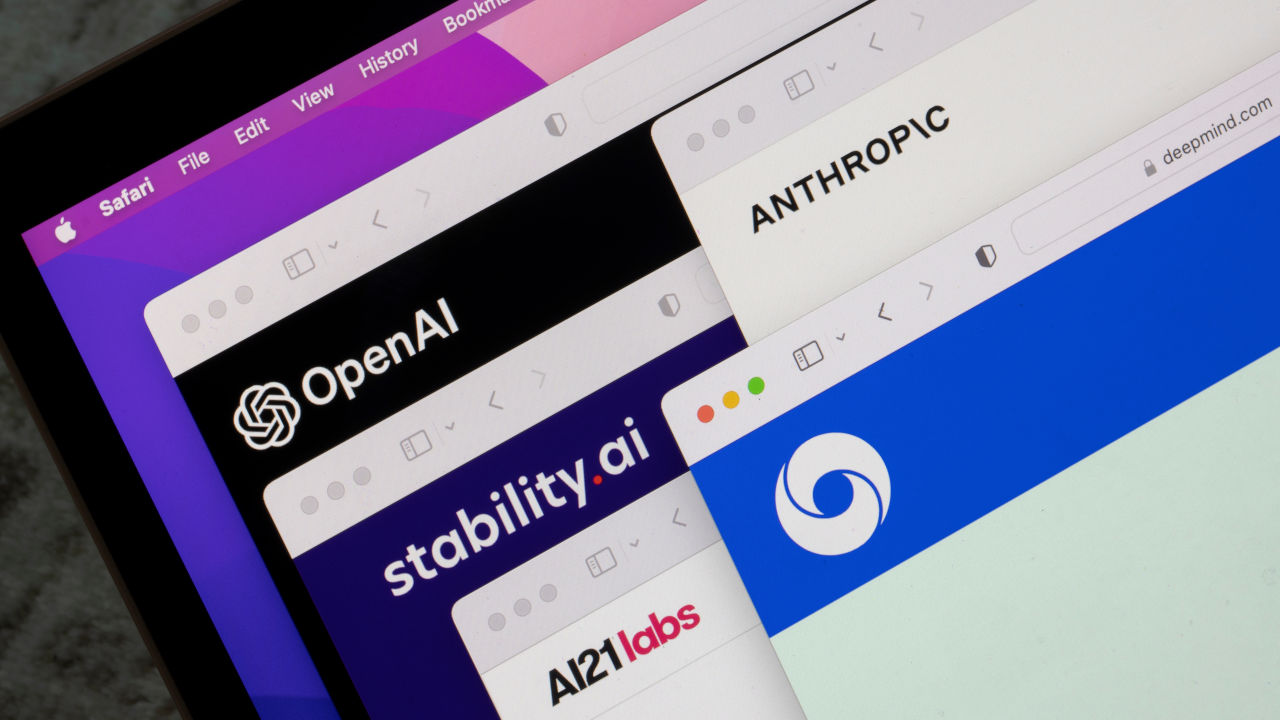

Large Language Models, utilizzi pratici

Tada Images/Shutterstock

Sono moltissimi i Large Language Models sul mercato e sono stati sviluppati da alcune delle aziende hi-tech più importanti del mondo, come OpenAI, Google, Meta e moltissime altre.

Generalmente questi modelli vengono utilizzati, come appena detto, all’interno dei vari chatbot sorretti dall’intelligenza artificiale che stanno diventando sempre più popolari e stanno entrando in contatto con tecnologie molto diverse tra loro.

Chiaramente si parla di una innovazione che gradualmente sta interessando tutti i settori tecnologici da quelli più specialistici, come le suite aziendali per la produttività fino ad arrivare alle soluzioni per l’intrattenimento o per le tecnologie di uso quotidiano, come gli smartphone.

Il perché di questa diffusione è semplice: perché sono sistemi estremamente versatili e possono essere utilizzati per alimentare un numero sterminato di servizi, da quelli legati alla customer assistant, fino ad arrivare ai motori di ricerca o agli assistenti vocali.

Gli sviluppi futuri di questi modelli sono incredibili e potrebbero davvero cambiare la vita delle persone: pensiamo al settore sanitario, con la possibilità di simulare l’evoluzione del quadro clinico di un paziente, ad esempio.

Naturalmente al momento si parla di un prodotto non è privo di errori e di quelle che vengono chiamate “allucinazioni”, ma il progresso tecnologico corre veloce e il destino di questi modelli è di diventare la chiave di lettura del futuro e già adesso è una previsione non troppo lontana dall’avverarsi.

Per saperne di più: Intelligenza Artificiale: cos'è e cosa può fare per noi